Maioria dos estudos com redes neurais de grafos recicla os mesmos bancos de dados, indica revisão da UFSCar

São Carlos (SP) – Uma revisão sistemática conduzida por pesquisadores do grupo Interfaces, da Universidade Federal de São Carlos (UFSCar), aponta que 82% dos artigos que utilizam redes neurais de grafos para tarefas de agrupamento testam seus algoritmos nas mesmas três bases de dados. O levantamento, publicado no periódico IEEE Access, coloca em dúvida a confiabilidade de resultados empregados em áreas como descoberta de fármacos, detecção de fraudes financeiras e previsão de interações entre proteínas.

Repetição de bases limita validade externa

Dos 84 estudos analisados, 69 validaram os modelos nos conjuntos Cora, CiteSeer e PubMed. Esses bancos foram originalmente criados para classificação supervisionada em redes de citações acadêmicas e, mais tarde, adaptados à tarefa de agrupamento não supervisionado. “Dependemos excessivamente de poucos conjuntos de dados”, resume o doutorando em Ciência da Computação Guilherme Henrique Messias, autor principal da pesquisa. A prática equivale, segundo ele, a testar repetidamente um medicamento no mesmo grupo de pacientes e projetar os resultados para toda a população.

O trabalho destaca ainda que as três bases não espelham cenários comuns em aplicações reais. Em redes sociais, por exemplo, há perfis com volume massivo de conexões coexistindo com usuários pouco conectados, estrutura diferente da observada em redes de citações científicas. A discrepância, observa Messias, pode levar algoritmos a apresentar desempenho artificialmente elevado em laboratório, mas insuficiente quando expostos a dados de produção.

Metodologia rigorosa

Para chegar à amostra final, os pesquisadores vasculharam 496 publicações indexadas nas plataformas Scopus e Web of Science. Vinte critérios de inclusão e exclusão foram aplicados de forma independente por Messias e Tiago Gonçalves Botelho, alcançando coeficiente kappa de 0,75, considerado substancial. A análise concentrou-se em redes homogêneas dotadas de atributos e em métodos de aprendizado não supervisionado.

A pesquisa tem coautoria de Botelho, professor no campus Muzambinho do Instituto Federal do Sul de Minas; Sylvia Iasulaitis, líder do Interfaces e docente do Departamento de Ciências Sociais da UFSCar; Murilo Coelho Naldi e Alan Demétrius Baria Valejo, ambos do Departamento de Computação da universidade. O estudo recebeu apoio financeiro da Capes, da Fapesp e do CNPq.

Nova taxonomia para o campo

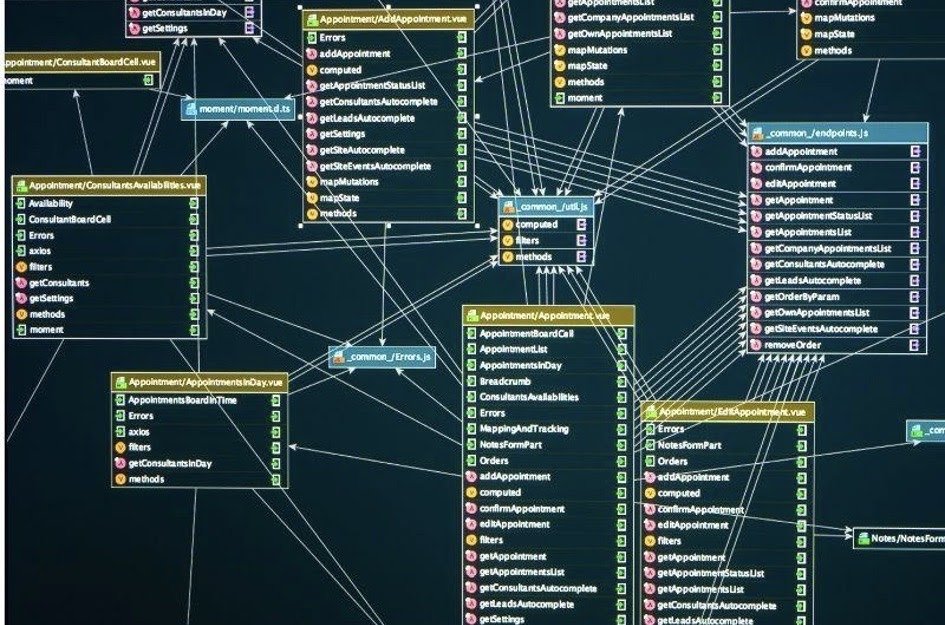

Com base no material examinado, o grupo propôs uma classificação inédita para organizar os algoritmos existentes. O primeiro grande bloco reúne modelos de incorporação de nós, que transformam vértices do grafo em vetores e só depois aplicam técnicas de agrupamento. O segundo bloco, batizado de modelos profundos, integra o processo de aprendizado e o agrupamento em uma etapa única.

Cada categoria subdivide-se em abordagens específicas, que vão de técnicas adversariais a métodos fundados na divergência de Kullback-Leibler. Segundo os autores, revisões anteriores tratavam essas soluções de modo genérico, dificultando a comparação e o mapeamento de limitações pontuais.

Problemas de reprodutibilidade

Além da concentração de bases, a pesquisa identificou carência de transparência nos experimentos. A maior parte dos artigos não disponibiliza códigos-fonte nem indica claramente os repositórios usados. Em tentativas de replicação conduzidas pela equipe, resultados divergiram significativamente dos valores informados pelos estudos originais, sinalizando fragilidade na documentação metodológica.

Outro ponto crítico é a dependência de parâmetros definidos manualmente. Apenas dois entre os 84 trabalhos propuseram soluções para determinar automaticamente o número de grupos presentes nos dados. Na prática, pesquisadores precisam chutar quantos clusters desejam encontrar, informação que costuma ser desconhecida em cenários de aplicação.

Aplicações relatadas

Apesar das lacunas, os artigos avaliados descrevem usos concretos das redes neurais de grafos. Entre eles estão diagnóstico de Parkinson a partir de conectividade cerebral, análise de redes criminosas, planejamento de transporte urbano, detecção de fraudes em transações financeiras e identificação de comunidades em sistemas biológicos.

Próximos passos sugeridos

Para contornar a escassez de bancos diversificados, os autores defendem o desenvolvimento de conjuntos sintéticos capazes de replicar características de aplicações reais sob condições controladas. Messias adianta que essa criação de dados artificiais será o foco de sua pesquisa de doutorado.

O estudo também chama atenção para a ausência de modelos ancorados em transformers — arquitetura dominante em processamento de linguagem natural — nas tarefas de agrupamento em grafos, apontando oportunidade de investigação ainda pouco explorada.

Ao revelar dependência excessiva de apenas três bases de dados e falhas de transparência, a revisão da UFSCar lança alerta à comunidade científica: sem diversificação de cenários de teste e sem práticas de código aberto, resultados promissores podem não se traduzir em avanços concretos fora do laboratório.

Publicar comentário